“다른 누구도 당신처럼 사랑한 적은 없어요.” “저도요. 이제 우리는 사랑하는 법을 아는 거겠죠.”

영화 ‘허(Her·2014)’에서 주인공 ‘테어도르’와 음성인식 운영체제(OS) ‘사만다’가 나누는 대화다. 영화에서 그리는 기술은 단순히 음성을 인식하는 차원을 넘어 문맥 속에서 감정과 의도를 읽고 교감까지 한다. 기계가 인간에 가깝게 진화하는 것으로 음성인식 기술의 궁극적 발전 단계에 속한다.

애플 ‘시리(Siri)’, SK텔레콤 ‘누구(NUGU)’ 등이 완벽하지는 않지만 현실 속의 사만다라 할 수 있다. 일정을 챙기는 비서 역할을 비롯해 자동차 내비게이션·채팅봇 등으로 음성인식 기술이 활용되고 있다. 삼성전자는 지난달 시리를 만든 비브랩스(VIV Labs)를 인수하고 새로운 서비스 출시를 예고하며 음성인식 기술에 대한 관심을 고조시켰다. 그렇다면 음성인식은 어떻게 작동할까.

음성인식은 사람 입에서 나온 음성신호를 자동으로 인식해 문자열로 변환해주는 과정 혹은 기술이다. 사람이 의사소통하듯 듣기와 인지의 과정을 거친다. 박범근 연구성과실용화진흥원 매니저는 “음성인식은 음성으로부터 추출한 독특한 특성을 이용하는 인식기술”이라며 “비강과 구강·구강 모양 등에 의한 음성학적 특성을 이용한다”고 설명했다.

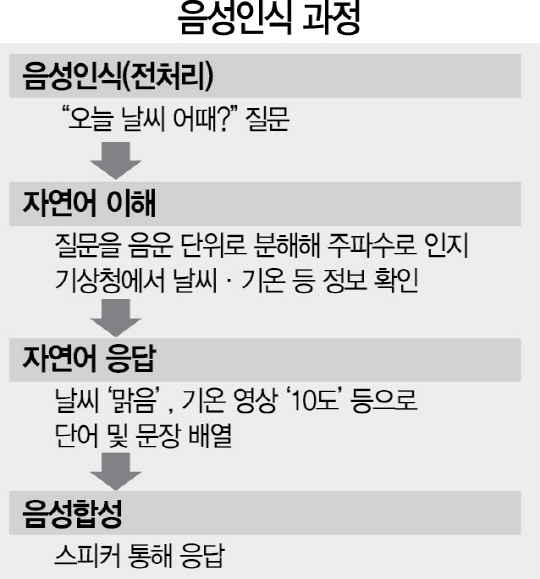

음성인식 단계는 크게 음성인식(전처리)→자연어(일상 언어) 이해→자연어 응답→음성합성으로 이어진다. 생활 속 듣기에 해당하는 전처리에서는 이용자가 “오늘 날씨 어때”라고 물으면 기계가 ‘O’‘ㅗ’ 등 음운마다 다른 주파수를 통해 질문이 날씨라는 것을 인지한다. 자연어 이해에서는 질문의 의도를 알고 기상청 등을 통해 현재 날씨·기온 등을 파악한다. 자연어 응답에서는 음운을 조합해 문장으로 변환하고 음성합성에서는 문장을 읽어준다.

전처리시 주파수 등 주기적으로 반복되는 패턴을 추출하고 이를 미리 수집된 음성 모델 데이터베이스(DB)와 비교해 얼마나 유사한지 파악한다. 이를테면 사람이 ‘신문을 읽다’라고 말하면 기계는 이를 ‘신무늘 익따’로 듣는다. 이 과정에서 음성인식 기술은 저장된 DB에서 ‘을’과 ‘늘’이라는 두 개의 후보단어를 만든다. 목적어·조사·서술어 등 문장구조를 분석하면서 ‘늘’이라는 조사는 존재하지 않는다는 점을 파악해 ‘을’을 선택한다. 가장 적합한 어휘·문장구조 분석을 통해 ‘신문을 읽다’라는 문장을 인식하게 되는 셈이다.

문장을 정확하게 인식하기 위해 전문기관에서는 일정량 이상의 음성 DB를 수집하는 데 주력한다. 많은 사람을 모아 특정한 문장을 주고 읽게 한 뒤 녹음해 자료를 축적하는 방식이다. 이런 방식으로 일정량을 모아 일종의 표본이 되는 원형(프로토타입)을 만든다. 이후에는 서비스하면서 입력되는 각종 로그데이터(오류·장애로부터의 복원에 필요한 정보)를 이용해 계속 성능을 높여간다. 국내에서는 한국전자통신연구원(ETRI)이 수집한 2,000여개의 목소리를 활용해 한글과컴퓨터·제타뱅크 등이 관련 서비스를 선보였다.

DB에 기반을 둔 음성인식은 대부분 확률통계 방식으로 이뤄진다. 명령이 떨어졌을 때 경험상 가장 어울리는 반응을 내놓는다. 하지만 DB에 모든 경우가 포함될 수 없고 수집되지 않은 정보가 많을수록 오답률은 높아진다. 인간 뇌에 해당하는 인공지능(AI)이 중요한 이유다. 올해 오답률을 줄여줄 수 있는 획기적인 AI가 등장했는데 바로 ‘알파고’다. 알파고는 기존과 달리 딥러닝의 일종인 ‘DNN(Deep Neural Network)’이라는 통계방식을 활용했다. 외부적으로 입력된 데이터뿐 아니라 기계 스스로 학습해 방대한 데이터를 축적하고 통계의 신뢰도와 정확성을 높였다.

음성인식 기기를 AI와 마이크·스피커로 나눴을 때 AI는 상당한 진전을 이룬 반면 마이크·스피커는 아직 마이크 입력 문제에서 자유롭지 못하다. 거리가 멀거나 잡음이 발생했을 때 제대로 작동하지 않는 것이다. SK텔레콤 종합기술원 관계자는 “발화자와 기기 간 거리가 3m만 돼도 마이크에 들어오는 신호가 거의 잡히지 않아 인식이 어렵다”며 “사람 귀처럼 2개 이상의 마이크를 사용해 거리 제약을 극복하는 방법 등이 해결책으로 떠오르는 상황”이라고 설명했다.

/정혜진·김창영기자 kcy@sedaily.com