전자부품연구원(KETI)은 인공지능(AI)으로 오디오 음원을 분석해 보다 명확한 음성전달은 물론, 배경음악, 음향, 대사 등 구성음 간 최적화된 음량구성을 실시간 제공하는 음량 자동제어기술을 개발했다고 26일 밝혔다.

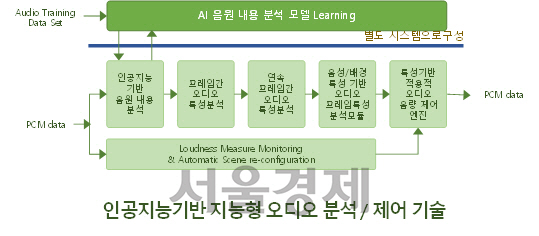

KETI가 개발한 ‘AI기반 오디오 음원분석 및 자동 음량 실시간 제어기술’은 딥러닝을 활용한 CNN(Convolutional neural networks) 기반 알고리즘으로 콘텐츠 내 소리를 400ms단위로 육성, 묵음, 배경음, 혼합음 등의 클래스로 구분하고, 클래스에 따라 맞춤형으로 음량을 제어하도록 고안됐다. 웅얼거리는 듯 들릴 수 있는 대사음량은 키워주고, 과도한 배경음향은 줄이는 등 기존 콘텐츠의 음성 명료도를 개선하고 급등락하는 소리의 상대적 편차를 줄여 편안한 청취 환경을 제공하는 동시에 라이브방송 시에도 평균음량 규정을 실시간으로 맞출 수 있는 장점이 있다.

김제우 KETI 지능형영상처리연구센터 수석은 “이번 기술개발로 100% 해외의존 중인 실시간 음량제어 방송장비의 국산화가 기대된다”며 “디지털 방송 외에도 인터넷 개인방송, 소셜 미디어 등 퍼스널 미디어시장이 지속성장하고 있는 만큼 앞으로 편안한 시청환경 구축에 KETI 기술이 활용될 것”이라고 말했다.

이 기술은 과학기술정보통신부와 정보통신기획평가원(IITP)의 ‘방송통신산업기술개발사업’으로 지원된 ‘딥러닝기반 지능형 오디오 분석을 통한 오디오 콘텐츠 변환 솔루션 개발’ 과제로 개발됐다. 현재 주관기관인 네오컨버전스주식회사로 기술이전돼 사업화가 진행 중이다.