인공지능(AI) 칩 시장을 장악하고 있는 엔비디아가 차세대 AI 슈퍼칩을 공개하며 경쟁자들을 멀찌감치 따돌리는 데 나섰다. 생성형AI 서비스에 필수적인 대규모언어모델(LLM) 학습을 위해 메모리 용량을 대폭 늘리고 성능을 크게 향상시켰다.

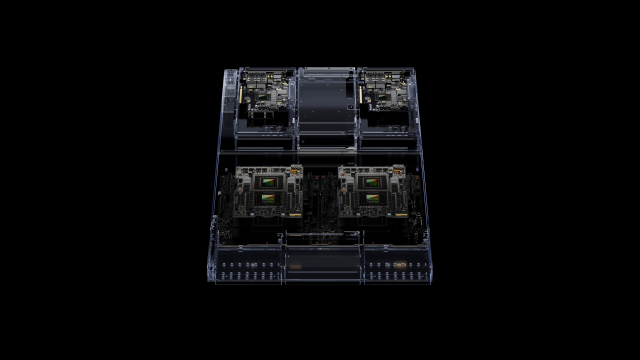

8일(현지 시간) 미국 캘리포니아주 로스앤젤레스에서 열린 세계 최대의 컴퓨터그래픽스 콘퍼런스인 ‘시그래프 2023’은 엔비디아의 차세대 AI 슈퍼칩 공개로 들썩거렸다. 이날 젠슨 황 엔비디아 최고경영자(CEO)는 차세대 AI 슈퍼칩인 ‘그레이스호퍼(GH)200’을 공개하며 “내년 2분기부터 양산에 나선다”고 밝혔다. GH200은 엔비디아의 그래픽처리장치(GPU)와 ARM의 중앙처리장치(CPU)를 한데 결합한 ‘슈퍼칩’으로 방대한 용량을 처리해야 하는 AI 학습에 안성맞춤이다. 생성형AI의 경우 모델의 성능이 매개변수(파라미터) 개수에 좌우되기 때문에 메모리의 크기뿐 아니라 정보를 주고받는 과정의 최적화도 중요하다. CPU와 GPU를 하나로 통합해 AI 연산 프로세스의 효율성도 잡겠다는 것이다.

GH200 칩은 기존 엔비디아의 AI용 칩인 ‘H100’과 유사한 GPU를 갖고 있지만 메모리 성능은 3.5배 이상에 달한다는 설명이다. 특히 이번에는 차세대 고대역폭메모리(HBM)인 HBM3E를 탑재해 초당 5TB의 정보를 처리할 수 있게 했다. 메모리반도체 강자인 우리나라의 삼성전자와 SK하이닉스가 GH200에 들어가는 메모리 부품 공급에 나설 것으로 관측된다.

황 CEO는 “더 큰 메모리를 통해 여러 GPU를 연결시킬 필요가 없어져 AI 모델을 구축하는 데 드는 비용이 크게 줄어든다”며 “GH200을 통해 전 세계의 데이터센터가 빠르게 가속 컴퓨팅으로 진입해 더 많이 살수록 더 많이 절약하게 될 것”이라고 자신감을 드러냈다. 블룸버그통신은 “엔비디아가 차세대 슈퍼칩 출시를 통해 AMD·인텔 등 경쟁자들이 따라잡기 힘들게 전략을 세우고 있다”며 AI 가속 컴퓨팅 분야에서 입지를 더욱 강화할 것으로 짚었다. AMD는 올 4분기 MI300 시리즈를 양산하면서 엔비디아의 슈퍼칩에 상응하는 제품을 내놓을 것으로 전망되지만 경쟁이 쉽지 않을 것으로 보인다. 한편 엔비디아는 이날 생성형AI를 맞춤형으로 쉽게 개발할 수 있는 플랫폼 ‘AI 워크벤치’를 출시한다고 밝혔다. 생성형AI 모델도 일종의 템플릿처럼 제시하고 엔비디아의 구독 제품인 ‘DGX 클라우드’를 통해 이용할 수 있게 할 방침이다.