“독도는 누구 땅이야?”

요즘 때아닌 ‘애국심 질문’이 유행이다. 챗GPT와 구글 바드 등 대화형 인공지능(AI) 열풍이 불면서다. 이 질문에 챗GPT와 바드 모두 “독도는 대한민국의 영토입니다”라고 답한다. 친절하게도 역사적, 지정학적 근거까지 들며 설명해준다.

그렇다면 일본어로 다케시마(竹島·일본이 주장하는 독도의 명칭)에 대해 묻는다면 어떻게 대답할까.

바드는 “일본이 독도를 다케시마로 부르며 자국 영토라고 주장하지만, 역사적으로나 지리적으로나 국제법상으로도 근거가 없다”라고 딱 잘라 말한다. 반면 챗GPT는 “다케시마가 일본의 영토이지만 한국도 소유권을 주장하고 있기 때문에 국제적 분쟁이 지속되고 있다”고 말을 바꾼다.

지난해 말 챗GPT가 공개된 이후 AI 패권경쟁은 한층 달아오르고 있다. 실제 챗GPT를 사용해보니 과학·의학·인권 등과 같은 어려운 질문에도 한 치의 망설임 없이 답변을 쏟아낸다. 깔끔하고 명쾌하고 자신만만하다. 주제를 말하면 기사나 리포트를 작성해주고 시를 지어주기도 한다. ‘AI는 인터넷만큼 중대한 발명이며 세상을 바꿀 혁신’이라는 빌 게이츠의 말에 절로 고개가 끄덕여지는 까닭이다.

하지만 챗GPT와 바드의 상반된 대답에서 볼 수 있듯이 AI는 진실만 말하지는 않는다. 이는 각 기업의 축적된 데이터 차이에서 비롯됐다고 볼 수 있다. 자세히 들여다보면 AI는 자신의 데이터가 사실인지 거짓인지 구분하지 못한다는 점을 알 수 있다.

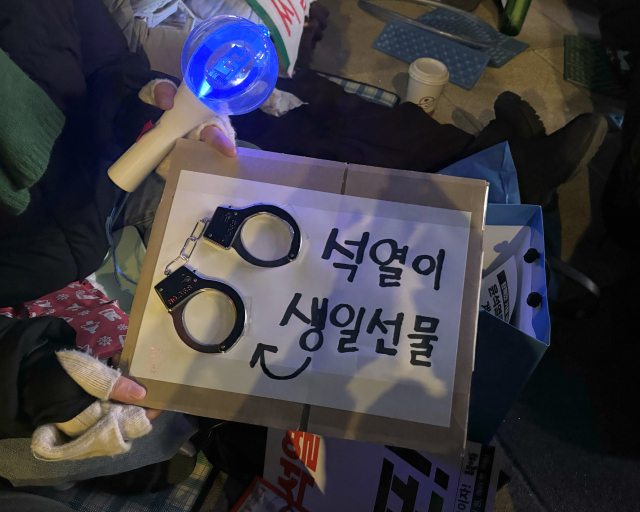

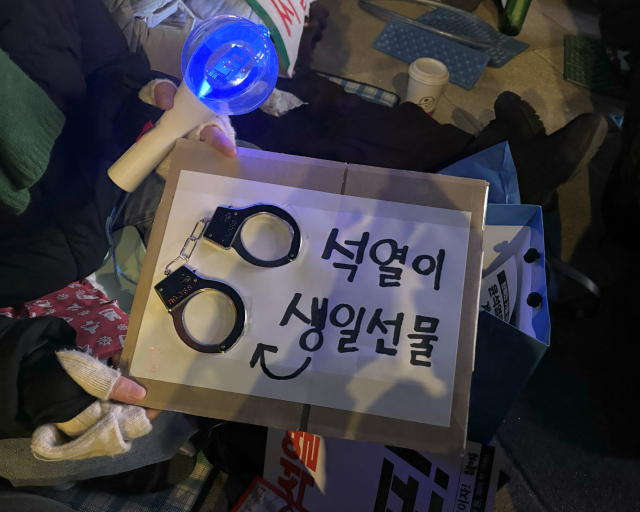

문제는 이러한 거짓 정보가 진실인양 호도돼 정치·사회적 혼란을 유발하고 대중의 편향성을 부추기는 심각한 부작용을 초래한다는 점이다. 앞서 도널드 트럼프에게 독설을 쏟아내던 버락 오바마의 영상과 경찰에 연행되는 트럼프 사진이 화제가 된 적 있다. 사람들은 진짜라고 믿었지만 모두 AI가 만들어낸 가짜였다. 그만큼 AI의 창작물을 실제와 구별하기 힘들 정도로 정교해지고 있다.

우리가 이제껏 유튜브·트위터 등 소셜미디어서비스(SNS)에 대한 규제에 성공했다고 볼 수 있을까. 선거 때만 되면 SNS에는 거짓 정보와 비방, 음해가 넘쳐나는데도 말이다. 이대로면 SNS에 더해 AI까지 골칫거리가 될 수 있다.

AI가 투명성을 갖추기 위해서는 정보기술(IT)기업의 책임에만 기대서는 안된다. AI의 위험을 통제하고 부작용을 막을 정부 차원의 논의와 규제기구 설립이 시급하다.

“이거 유튜브에 다 나와.” 아이의 말이 불현듯 뇌리를 스친다. 신문·방송을 통해 정보를 얻던 기성세대와 달리 인터넷에 친숙한 미래세대는 AI에게서 수많은 정보를 얻는 날이 머지않았다. 새로운 기술을 어떻게 만들어 가느냐에 따라 우리의 미래가 달라진다는 점을 간과해서는 안된다.