딥페이크 음성이 보이스피싱 범죄 등에 악용돼 피해가 커질 수 있어 ‘딥페이크 음성 탐지 기술’ 개발에 집중해야 한다는 주장이 나왔다.

20일 정보통신기획평가원(IITP) 주간기술동향에 따르면 최근 딥페이크 음성은 △보이스피싱 △가짜뉴스 △불법 선거 △투자 사기 △목소리 도용 등에 악용되고 있다.

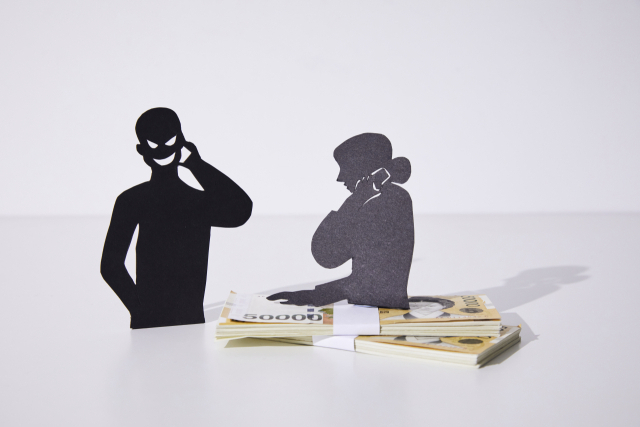

보이스피싱 범죄의 경우 자녀나 가족의 목소리를 딥페이크로 모방한 음성으로 도움을 요청하는 척하며 금전을 갈취하는 방식으로 이뤄진다. 투자 사기 범죄 역시 유명인의 목소리를 딥페이크로 변조해 투자자에 대한 신뢰를 높이는 방식으로 발생한다.

보고서에서 홍기훈 숭실대학교 교수는 실제 목소리를 부분 변조하는 방식으로 딥페이크 음성인지 여부를 파악하기 어렵게 만들어 관련 범죄 발생 가능성을 높인다고 지적했다. 부분 변조 음성은 대부분의 음성이 사람 음성이고 일부분만 딥페이크 음성이기 때문에 일반적인 탐지 시스템에서는 사람 음성으로 판단한다고 홍 교수는 설명했다.

최근 전세계적으로 딥페이크 불법 합성물 피해가 확산하면서 미국과 유럽연합(EU) 등은 딥페이크 규제 정책을 잇따라 발표했다. EU는 디지털서비스법(DSA)을 마련하고 생성·조작된 비디오나 오디오, 이미지는 실존 인물이나 사물과 식별할 수 있게 표시할 수 있도록 규정하고 있다. 미국은 ‘딥페이크 책임법안’에 AI 기술로 만들어진 영상이나 시각물이라는 점을 식별할 수 있도록 규정했으며 이를 어길 경우 형사처벌이나 피해자 지원, 딥페이크 탐지 등에 대한 내용까지 포괄적으로 다루고 있다. 한국은 공직선거법을 개정해 선거일 90일 전부터 선거운동을 위한 딥페이크 영상의 제작 및 유포 등을 금지했다. 성폭력범죄의 처벌 등에 관한 특례법 일부 개정안을 통해서도 딥페이크 범죄를 간접으로 규제하고 있다.

홍 교수는 딥페이크 음성을 악용한 피해를 막으려면 ‘딥페이크 음성 탐지 기술’을 개발하는 등 다양한 연구를 통해 안전한 AI 활용 환경을 구축해야 한다고 강조했다. 그는 “가짜 음성은 잘못된 정보를 직접 전달할 수 있어 딥페이크 음성 탐지의 중요성이 점점 커지고 있다”면서 “이같은 기능을 필요로 하는 국가 기관과 연구 기관들의 관심으로 다양한 연구가 진행돼 딥페이크를 탐지하는 안전한 AI 활용 환경이 구축돼야 한다”고 말했다.