국내 연구팀이 3차원 공간에서 생각만으로 로봇 팔을 높은 정확도(90.9~92.6%)로 조종하는 ‘뇌-기계 인터페이스 시스템’을 개발했다. 이번에 개발된 기술은 메타버스(3차원 가상세계)에서 아바타를 생각대로 움직이게 하거나 애플리케이션을 생각만으로 제어하는 스마트 기기 등에 광범위하게 사용될 수 있다.

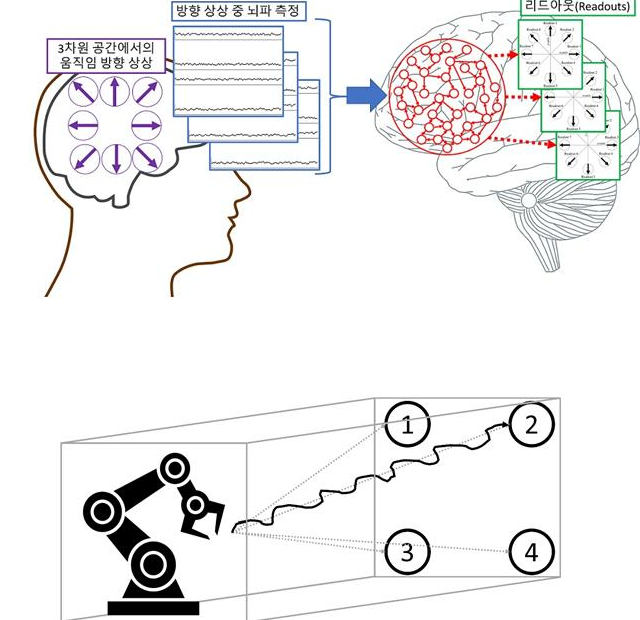

한국과학기술원(KAIST·총장 이광형)은 정재승 바이오 및 뇌공학과 교수 연구팀이 인공지능(AI)과 유전자 알고리즘을 사용해 인간 대뇌 심부에서 측정한 뇌파만으로 팔 움직임 의도를 파악해 로봇 팔을 제어하는 새로운 형태의 뇌-기계 인터페이스 시스템을 개발했다고 23일 밝혔다.

최근 뇌 활동만으로 사람의 의도를 파악해 로봇이나 기계가 대신 행동에 옮기는 ‘뇌-기계 인터페이스’ 기술은 급속히 발전하고 있으나 정교하게 로봇 팔을 움직이는 기술은 아직까지 정확도가 높지 않다.

연구팀이 만든 뇌-기계 인터페이스 AI 모델은 3차원상에서 스물네 가지 방향, 즉 각 차원에서 여덟 가지 방향으로 움직일 수 있다. 정확도가 모든 방향에서 평균 90% 이상(90.9~92.6% 범위)을 기록했다. 더욱이 기존 기계학습 기술은 높은 사양의 GPU 하드웨어가 필요하지만 이번 연구는 축적 컴퓨팅 기법을 활용해 낮은 사양의 하드웨어에서도 AI 학습이 가능하다. 스마트 모바일 기기에서도 폭넓게 응용될 수 있도록 개발했다. 앞으로 메타버스와 스마트 기기에도 적용이 가능하게 된 것이다.

이번 연구에 제1저자로 참여한 김훈희 KAIST 박사(강남대 조교수)는 “앞으로 뇌의 특성을 좀 더 구체적으로 이용한 ‘뇌 모방 AI’를 활용해 다양한 뇌-기계 인터페이스를 개발할 것”이라고 포부를 피력했다.